Tinc set de dades!

16 juliol, 2020 - Jordi Serra Serra, Cap de Sistemes d’Informació i Disseny de Processos del Consorci d’Educació de Barcelona

L’arxiver, per la seva proximitat a la gènesi de la informació dins les organitzacions, es converteix en el garant de la fiabilitat de la dada, i per tant en el principal proveïdor de fonts per a l’analítica de dades.

Reinventar la roda és darrerament l’exercici que moltes disciplines practiquen assíduament, i que serveix per alimentar la insaciable voracitat de novetats del món de les xarxes socials. I en aquest context, quan parlem de dades, tot és nou i tot és futur. Abocar petabytes de raw data provinents de sistemes no connectats en un data lake i explotar-les amb Hadoop se’ns presenta com una revolució enfront de les formes d’explotació de la informació més convencionals (data warehouse i models relacionals). Això s’esdevé en el mateix context on la robotització es planteja com l’alternativa definitiva al desenvolupament de pesats sistemes de gestió (incloent-hi els de gestió documental), i el machine learning com el substitut natural del tradicional anàlisi de funcions i activitats d’una organització i de qualsevol sistema de classificació humà.

Els tres exemples comparteixen un denominador comú: el reconeixement de la incapacitat de les organitzacions per ordenar el caos i sistematitzar el seu funcionament. Siguem realistes: després d’anys de treballar-hi, poques organitzacions han assolit un nivell realment alt d’interoperabilitat entre els seus sistemes d’informació, superant la tradicional separació en “silos” desconnectats. Poques organitzacions han aconseguit tampoc una transformació dels seus processos a un nivell que permeti que tots estiguin no només automatitzats sinó també basats en informació estructurada (i si més no normalitzada). I poques organitzacions han aconseguit una implantació completa de sistemes de gestió documental en el 100% dels processos de creació de la informació. En el moment en què la capacitat d’anàlisi de dades ha crescut per sobre de la capacitat de les organitzacions d’ordenar la seva informació en un temps i a un cost raonables, s’ha començat a generar la il·lusió (certa o falsa) que aquesta ordenació de la informació ha deixat de ser un requisit imprescindible per poder treure el màxim profit de les dades acumulades, i que la sola anàlisi de les dades és estímul suficient per a la intel·ligència col·lectiva que pot conduir una organització pel camí de l’encert.

Aquesta il·lusió, no ens enganyem, posa en risc la supervivència del treball desenvolupat durant molt de temps pels arxivers[1], i de les metodologies que aquest treball ha construït. Però no només això. També posa en risc el treball dels professionals d’organització que s’ocupen de la sistematització dels processos, i dels professionals de les TIC que desenvolupen solucions per a fer que aquesta sistematització es faci efectiva en el dia a dia. Són prescindibles, doncs, aquests elements quan disposem de màquines que aprenen i prenen automàticament decisions a partir d’oceans de dades no sistematitzades?

Només quan ens endinsem en projectes d’analítica de dades ens adonem de la insaciable set de dades d’aquesta disciplina, de com les necessita per viure i produir resultats sovint gairebé màgics. Però no de qualsevol mena de dades, sinó de dades certes, actuals i úniques. Per molt que apliquem analítica de Big Data, sense determinades dades inicials de referència (dades mestres i transaccionals[2]) no és possible treure conclusions significatives sobre la resta d’informació, o en tot cas conclusions que puguin tenir aplicació directa en la gestió diària de les organitzacions. Els científics de dades coincideixen en afirmar que, en la majoria de projectes d’analítica de dades, prop d’un 80% del temps es dedica a netejar i incrementar la qualitat de les dades (data cleansing o data scrubbing)[3], per tal de poder treballar sobre una base el més propera possible a la realitat sobre la qual es busca poder intervenir. I, especialment en l’àmbit públic, només un percentatge d’aquests projectes assoleix resultats que després es tradueixin en polítiques concretes aplicades a les organitzacions.

Un 80% del temps de projecte destinat només a obtenir dades, netejar-les i posar-hi ordre! Pocs arxivers admetrien aquest malbaratament en un projecte de gestió documental.

El front en la lluita per a la qualitat de les dades segueix trobant-se doncs en les dades de gestió, en aquelles dades que es produeixen com a resultat natural de l’activitat de les organitzacions. I en aquesta trinxera, l’activitat dels arxivers segueix essent d’un valor incalculable, i la clau per a la detecció d’aquells registres d’activitat on trobarem la dada única que serveix de referència per a les anàlisi que es vulguin emprendre.

L’arxiver, per la seva proximitat a la gènesi de la informació dins les organitzacions, es converteix doncs en el garant de la fiabilitat de la dada, i per tant en el principal proveïdor de fonts verificades, úniques i de qualitat per a l’analítica de dades. I això és així per tres motius:

- En primer lloc, perquè l’arxiver participa directament en la transformació dels processos, i a través d’aquesta transformació determina quines dades es generaran, en quin moment, qui els donarà veracitat (doncs en determina els mitjans d’autentificació), on s’emmagatzemaran, i durant quant de temps estaran disponibles. No només això: també en pot determinar quan escaigui l’estructura, la sintaxi i les fonts de control dels valors. I un element molt important: en un escenari d’actualització contínua, on les dades són tremendament volàtils i captives de l’interès del moment, l’arxiver pot contribuir a la consolidació d’aquella informació que, un cop historificada, ha de servir de referència per analitzar evolucions, tendències i donar persistència al sistema.

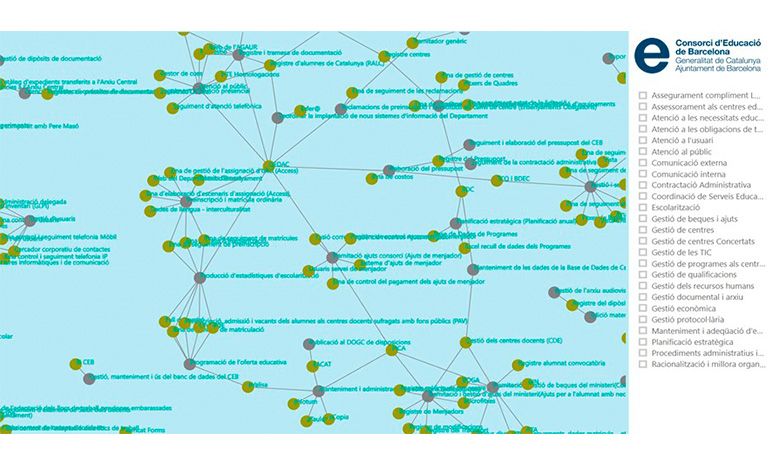

- En segon lloc, perquè l’arxiver és qui millor sap, per al conjunt de l’organització, qui genera cada dada, en quin moment ho fa, per quin motiu, i on la desa. I qui, per tant, pot apuntar amb més precisió, per a cada dada, a la font més fiable dins l’organització (fins i tot en aquells casos on els sistemes d’informació originals no s’han transformat, o els processos encara estan en un estadi embrionari de millora). L’arxiver sap, per exemple, qui manté un full de càlcul com eina per al seguiment d’un tràmit, o qui obté les dades d’una font verificada per interoperabilitat. Però el més important: l’arxiver sap quins vincles hi ha entre les dades d’un tràmit i les d’un altre, entre les que genera un agent i les que consumeix un altre, les que s’obtenen de fonts externes i les que es fabriquen a mida. Coneix les redundàncies i asincronies de la informació, i de la mateixa manera que assenyala quins són els documents originals i amb valor essencial, pot assenyalar en quin sistema es troba la dada única en cada faceta del mapa de dades de l’organització.

- I en tercer lloc, perquè l’arxiver no només coneix les dades pròpies, sinó també el mapa de relacions de les dades de l’organització amb totes aquelles dades de l’entorn amb les quals poden existir vincles. I un exemple clar d’això és el coneixement que, especialment en l’àmbit públic, els arxivers tenen de les obligacions de transparència i de les múltiples fonts de dades obertes, sovint negligides o directament ignorades en nombrosos projectes d’analítica de dades.[4] L’arxiver analitza les necessitats d’informació externa dels tràmits, i per tant sap exactament d’on provenen les dades, i si escau qui les podria facilitar.

Però a més l’arxiver pot esdevenir una important font de benefici econòmic per a les organitzacions. Segons Gartner, el 25% de les empreses actuals són compradores i venedores de dades, i es preveu que aquest percentatge s’incrementi a un 35% en només dos anys. La capacitat de monetitzar el capital informatiu d’una organització depèn de la capacitat de governar encertadament aquest capital. I una eficaç governança de les dades permet incrementar la qualitat de les dades, cosa la qual de retruc incrementa la seva cotització en el mercat de la informació.

Quan parlem de l’aportació dels arxivers no estem parlant només d’aplicar sistemes de classificació i regles de conservació, ni tampoc de gestionar dipòsits d’objectes digitals. Estem parlant de governança de la informació en majúscules, és a dir d’entrar a fons en el disseny dels sistemes d’informació de negoci, mapejar-ne les dades i les relacions dinàmiques que s’estableixen entre aquests sistemes i els processos als quals donen suport, i veure com això va configurant l’arquitectura d’informació de l’organització.[5] Procés a procés, activitat a activitat, l’arxiver ha d’analitzar el flux de dades que permet completar aquestes activitats, on s’emmagatzemen les dades, quina és la seva fiabilitat, autenticitat i nivell de normalització, quin consum fa el procés de dades externes, i quines d’aquestes dades formen part d’un model comú al conjunt de l’organització (dades horitzontals). Només aquesta anàlisi pot transcendir la visió típicament vertical dels sistemes-silo, i pot proveir fonts de gran valor per a l’analítica avançada i predictiva.

Però no podem perdre temps: la mateixa tasca de governar la informació està essent objecte de robotització.[6] L’aplicació d’intel·ligència artificial a la gestió de les dades (el que Timothy King anomena gestió de dades augmentada[7]) pot fer, segons Gartner, que en els pròxims dos anys les tasques manuals associades a la gestió de dades es redueixin en un 45%. Tant de bo que aquesta reducció no es faci a costa del pes específic de l’arxiver, sinó que, al contrari, en consolidi el seu valuós i creixent paper de facilitador de dades de qualitat.

[1] Utilitzo el terme arxiver, al llarg de l’article, com a sinònim de professional de la gestió documental i de la informació dins l’organització.

[2] Thomson, Sara Day. Preserving transactional data. DPC Technology Watch Report 16-02, maig de 2016.

[3] A títol d’exemple: What does a data analyst do? Plenty of cleaning up, it seems, Los científicos de datos pasan el 80% del tiempo limpiando datos y el otro 20% protestando por tener que limpiarlos SEDIC – Blog, La importancia de limpiar, seleccionar y transformar los datos – Cleverdata

[4] Només cal veure el baix ús que ha tingut el dataset de mortalitat observada vs. esperada (MoMo) en plena pandèmia del Covid-19, i en plena discussió pública sobre el recompte de defuncions i la incidència real de la mortalitat per Covid-19. MoMo és un sistema per a la vigilància de la mortalitat diària per totes les causes a Espanya, gestionat pel Centro Nacional de Epidemiología, que té com a objectiu identificar patrons inusuals de mortalitat i estimar l’impacte en la mortalitat de la població de qualsevol esdeveniment d’importància. Sorprèn doncs que la informació que proporciona sobre la mortalitat per tota mena de causa a Catalunya, disponible en format de dades obertes, només ha registrat des de la seva publicació el 27 d’abril de 2020 un total de 419 accessos, i només ha estat descarregada 137 vegades.

[5] En la línia que ja s’ha vingut treballant els darrers anys a Catalunya, com per exemple s’exposa a Serra, L. E. C. “The mapping, selecting and opening of data: The records management contribution to the Open Data project in Girona City Council”. Records Management Journal, 24(2), 2014. O per exemple també el plantejament integral abordat pel Consorci d’Educació de Barcelona, i presentat al darrer Congrés de Govern Digital.

[6] Res de nou, atenent crides com la de Bailey, S. “Forget electronic records management, it’s automated records management that we desperately need”. Records Management Journal, 19(2), 2009. Però en tot cas, brutalment accelerat pel creixement actual del machine learning.

[7] Augmented Data Management Is a Top Technology Trend for 2019

Deixa un comentari